Depuis leur création, les drones génèrent beaucoup d’inquiétudes. Outre les possibilités d’espionnage qu’ils offrent, c’est bien leur capacité d’armement qui effraie et surtout… leur autonomie grandissante.

À voir aussi sur Konbini

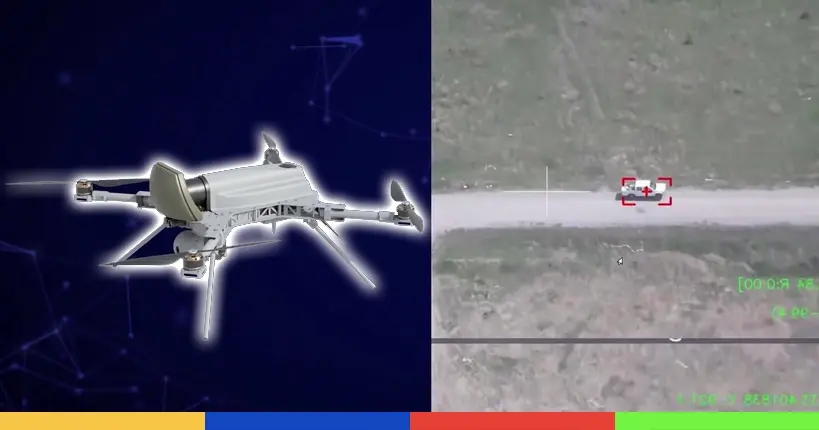

Un édifiant rapport du Conseil de sécurité des Nations Unis affirme qu’un drone aurait attaqué, en complète autonomie, des humains. Publiées en mars, 548 pages font état d’un modèle quadricoptère Kargu-2 produit par la société de technologie militaire turque STM. C’est en Libye que cette machine aurait tiré sur des soldats restés fidèles à Khalifa Haftar, général séditieux officiellement allié depuis un an au régime syrien de Bachar el-Assad.

Au cours de l’année, le gouvernement local reconnu par l’ONU avait repoussé les forces affiliées à Haftar (HAF) de la capitale Tripoli. De son côté, le modèle de drone d’attaque en question serait déjà opérationnel depuis janvier 2020. Le rapport soulève ainsi :

“Les convois logistiques et les forces du HAF en retraite ont été traqués et engagés à distance par les véhicules aériens de combat sans pilote ou les systèmes d’armes létales autonomes tels que le STM Kargu-2.”

Le rapport décrit la machine en question, expliquant que via des systèmes d’apprentissage, elle serait capable d’identifier les cibles à abattre. Les experts insistent particulièrement sur le fait qu’aucune connexion entre le drone et un opérateur n’est nécessaire pour autoriser les armes létales à tirer. De fait, ces robots autonomes sont capables de “trouver, tirer et oublier” selon les mots du rapport.

L’interdiction des “armes autonomes offensives” relancée

Depuis plusieurs années, des personnalités allant de Elon Musk à Noam Chomsky en passant par Stephen Hawking ont lancé divers appels pour interdire les “armes autonomes offensives” visant précisément ces drones ayant un droit de vie et de mort sur l’humain, sans que ce dernier n’intervienne dans leur décision.

Nombreux sont les experts à lever les drapeaux rouges en expliquant que l’intelligence artificielle embarquée qui permettrait en théorie d’identifier (et d’épargner) des cibles civiles ne serait pas suffisamment complexe pour qu’on lui accorde une confiance aveugle.

Pour le consultant en sécurité national Zachary Kellenborn, expert en véhicules aériens sans pilote, ces drones autonomes offensifs pourraient être particulièrement dangereux en “essaim”. Comme il l’explique dans un billet publié dans The Bulletin, leurs capacités de coordination et de communication entre eux (sans intermédiaire humain) pourraient mener à énormément “d’erreurs en cascade” si un drone commet une erreur et “contamine” les autres.

“Si quelqu’un était tué dans une attaque autonome, cela représenterait probablement un premier cas historique connu d’armes autonomes basées sur l’intelligence artificielle utilisées pour tuer”, a-t-il ajouté.

Pour nous écrire : hellokonbinitechno@konbini.com