Le Pixel 4 débarque en magasin ce vendredi 25 octobre. Disponible à partir de 769 euros, le nouveau smartphone de Google a fait beaucoup parler de lui ces dernières semaines.

À voir aussi sur Konbini

Et pour cause : succédant à un Pixel 3 qui s’était imposé comme roi de la photographie en 2018, le Pixel 4 veut surclasser son grand frère avec de nouveaux capteurs d’images et un écran 90 Hz absolument magnifique. Mais c’est surtout grâce à un ensemble de nouvelles technologies que Google veut marcher sur la concurrence, l’astrophotographie, la reconnaissance faciale et le Motion Sense en tête de liste.

C’est cette dernière qui nous intéresse aujourd’hui : le microradar du Pixel 4, baptisé Motion Sense par l’entreprise, est le résultat de cinq années de recherches d’un laboratoire de Google. Associé à un système d’intelligence artificielle, ce microradar est supposé comprendre vos gestes et même savoir si vous êtes dans les parages. En un mot, le Motion Sense du Pixel 4 veut ouvrir la voie du contrôle gestuel et de l’intelligence ambiante. Innovation véritable ou flop en puissance ?

Le microgeste qui ne compte pas vraiment

Nous avons le Pixel 4 XL, dans sa version 64 Go, entre les mains, depuis quelques jours. Dès le mois de juillet, une vidéo promotionnelle assez aguicheuse dévoilait le Motion Sense et laissait entrevoir les ambitions de Google dans l’utilisation du contrôle gestuel. Le but ? Pouvoir utiliser son appareil sans avoir à le toucher avec ses doigts sales ou trop occupés.

Comment ça fonctionne, au quotidien ? Un microradar est situé à l’avant du smartphone, prenant la forme d’un petit capteur. Il permet, sur une sélection d’applications (principalement musicales comme Spotify, Deezer ou YouTube Music), de changer de morceau sans toucher son téléphone. On peut également s’en servir pour arrêter une alarme en un geste.

Et… c’est à peu près tout. On en ressort avec un léger sentiment de déception et de frustration. Même si le radar en question est ultraréactif, on se demande pourquoi Google s’est limité à si peu d’applications après cinq longues années de recherches ?

Le Projet Soli, une puce pour l’avenir

Tentons de comprendre l’ambition qui se sache derrière ce microradar. Parce qu’en réalité, la différence entre ce que le Motion Sense fait sur le Pixel 4 et ce qu’il pourrait faire est énorme.

Le Motion Sense du Pixel 4 se résume en réalité à une puce minuscule, de la taille d’une carte SD, développée sous le nom de projet Soli. Les recherches autour de cette puce ont démarré en 2015, au sein des laboratoires de la Google’s Advanced Technology and Project (ATAP) et, à l’époque, la puce en question faisait la taille d’une boîte de pizza.

Ce qui distingue ce microradar du Face Unlock d’Apple ou même, si l’on remonte jusqu’en 2013, au Air Gesture introduit sur le Samsung S4, c’est précisément qu’il s’agit d’une puce et non d’une caméra. La puce utilise des ondes radios pour lire et interpréter nos gestes.

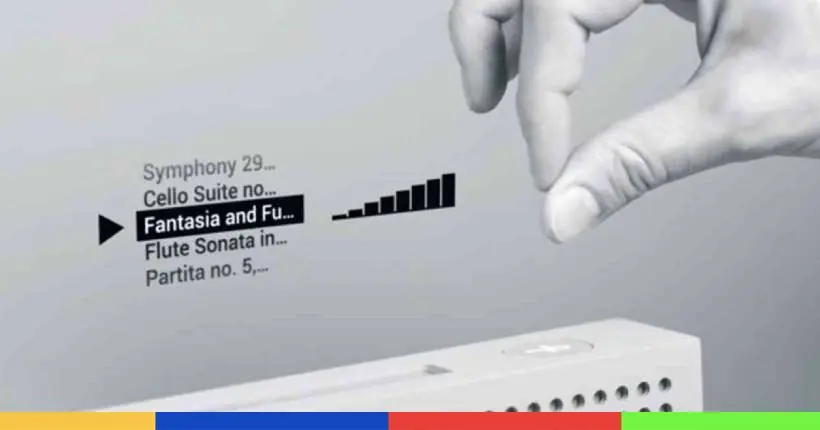

Ce qui lui offre, en théorie, un panel de capacités dépassant de loin celui d’une caméra. La puce Soli, appelée Motion Sense sur le Pixel 4, a conscience de la présence de l’utilisateur et peut reconnaître son environnement. Théoriquement, on pourrait changer de musique d’un geste de la main sans que celle-ci se situe au-dessus du smartphone, par exemple. À la manière de ces images dévoilées par Google, où l’on voit différentes applications de la puce.

Comme le racontaient nos confrères de Frandroid, la puce Soli a par exemple été utilisée en début d’année 2019 par des chercheurs de l’université de Saint Andrews, en Écosse, pour une batterie de tests. Ils ont montré que Soli était, par exemple, capable de compter le nombre de Lego posés sur le capteur ou lire le nombre de jetons de pokers empilés. “L’arrivée de radars miniatures à bas coût dans une utilisation quotidienne ouvre la voie à de nouveaux objets et de nouvelles interactions matérielles”, affirmait, en conclusion de son étude, le chercheur principal de l’étude, Hui Shyong Yeo.

Détecter un battement d’ailes de papillons

Dans un article passionnant sur le développement de la puce Soli, The Verge raconte s’être rendu dans les laboratoires de Google pour jeter un œil aux différentes utilisations de cette technologie. Dans la vidéo plus bas, on voit ainsi le journaliste utiliser le contrôle gestuel sur une enceinte connectée et une smartwatch – pour passer d’une application à une autre, par exemple.

Il ne s’agit, pour le moment, que de preuves de concept. “Nous pouvons détecter le mouvement d’un battement d’ailes de papillons”, affirme pourtant Ivan Poupyrev, directeur de recherche au sein de la Google ATAP, soulignant également que le radar Soli pourrait fonctionner à plus de sept mètres de distance.

Mais qui a besoin d’un capteur à la fois hypersensible dans la proximité et dans l’éloignement ? Personne, si aucune application véritablement pratique n’est trouvée pour celui-ci. La question est de savoir si l’expérience apportée par Soli pourrait, à terme, être meilleure pour l’utilisateur. “Au final, la technologie qui gagne est celle qui est le plus facile à utiliser, c’est aussi simple que ça”, continue Ivan Poupyrev. À voir, donc, si les futures applications de Soli pourront dépasser le côté gadget du radar utilisé sur le Pixel 4.

Aux portes de l’intelligence ambiante

Pour le moment, l’intérêt du projet Soli et son intégration dans le Pixel 4 réside dans l’intention, dans la philosophie de Google pour l’avenir. Au travers de ce premier microradar, c’est l’avènement de l’intelligence ambiante – ambient computing en anglais – que Google défend.

En un mot, Google veut que ses utilisateurs soient capables d’accéder à leurs services partout où ils sont et grâce à un ensemble de moyens et de commandes intuitives et immatérielles. L’idée serait que les services disparaissent en arrière-plan grâce à une technologie performante et, idéalement, invisible. Une technologie ouverte par l’arrivée des enceintes connectées et qui pourrait se traduire par de nombreuses applications dans le futur, à la manière du film Her, où l’intelligence artificielle est partout en étant nulle part à la fois.

“Notre vision pour l’intelligence ambiante est de créer une expérience unique et cohérente, à la maison et au travail, partout où vous en avez besoin”, disait Rick Osterloh, directeur du hardware chez Google, pas plus tard qu’à la mi-octobre. “Les appareils ne sont pas aux centres des systèmes technologiques, vous l’êtes. C’est notre vision de l’intelligence ambiante.” En un mot, Google prône l’arrivée d’une technologie si naturelle dans son utilisation qu’elle s’utiliserait, à terme, de façon totalement dématérialisée.

Et c’est aussi la vision que défend Ivan Poupyrev, patron du projet Soli. Dans une conférence TED intitulée “Tout autour de vous peut devenir un ordinateur”, donnée en mai dernier, l’ingénieur faisait une profession de foi en faveur d’un monde “devenu notre interface”.

Le capteur Soli est la première étape de cette vision. Encore imparfait, il ouvre la voie à de nombreuses applications. Et si ce radar ne trouvait pas sa finalité dans un smartphone, mais dans des applications domotiques ? Imaginez des lumières qu’on allume en claquant des doigts ou une douche qui change de température en tournant la main.